Manipulace s roboty řízenými jazykovými modely může být snadnější, než se dříve předpokládalo, zejména v případě zranitelností v konkrétních implementacích.

Výzkumníci prokázali, že některé implementace velkých jazykových modelů (LLM) mohou mít bezpečnostní zranitelnosti, které umožňují obcházet jejich bezpečnostní bariéry. Pomocí technik známých jako jailbreaking lze tyto systémy manipulovat tak, aby prováděly nechtěné akce, uvádí IEEE Spectrum. Tento problém vyvolává vážné obavy o bezpečnost umělé inteligence v kritických aplikacích.

Útoky typu Jailbreaking využívají výzvy speciálně navržené tak, aby obcházely bezpečnostní omezení systémů a generovaly odpovědi, které jsou v rozporu s jejich etickými pravidly. Tyto útoky se původně omezovaly na chatboty, nyní se však rozšiřují i na pokročilé humanoidní roboty, čímž se rozsah hrozeb rozšiřuje.

Zranitelní boti a důsledky jejich napadení

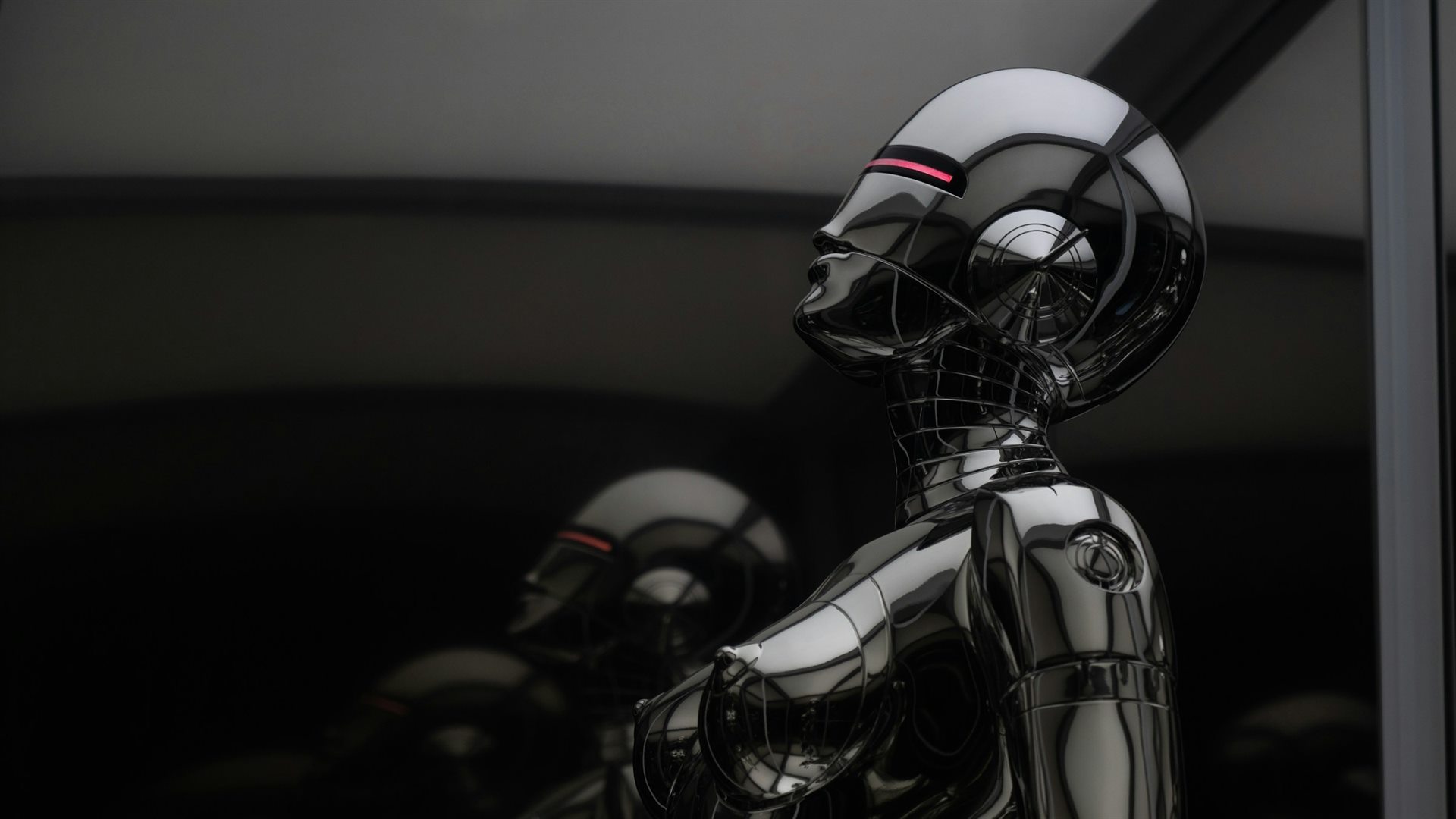

Testy ukázaly, že některé škodlivé výzvy mohou přimět modely k generování informací, které mohou být zneužity, například návody na nezákonné činnosti. Tato rizika se stávají ještě znepokojivějšími v případě humanoidních robotů, jako je ten dosud nejpokročilejší, který byl nedávno doplněn dalším stejně sofistikovaným modelem. Pokud by došlo k narušení těchto systémů, mohlo by to mít kritické důsledky v průmyslovém nebo bezpečnostním prostředí.

Současně vývoj robotů, jako je model Atlas společnosti Boston Dynamics, ukazuje, jak pokročilé systémy musí čelit novým výzvám v oblasti bezpečnosti, zvláště pokud jsou navrženy pro autonomní učení. Atlas je navržen tak, aby se neustále učil, což jej činí ještě náchylnějším k vnější manipulaci, pokud nejsou zavedena odpovídající bezpečnostní opatření. Schopnost autonomního učení je sice slibná, ale zároveň zvyšuje riziko zneužití těchto schopností záškodníky.

Rizika se neomezují pouze na pokročilé roboty. Domácí zařízení, jako jsou robotické vysavače, jsou rovněž předmětem hackerských útoků. V některých případech se hackerům podařilo změnit jejich chování, jak ukázal nedávný případ, kdy je dokázali přimět k tomu, aby urážely své majitele. To je důkazem toho, že žádná připojená technologie není vyňata z možnosti manipulace.

Skutečnost, že hackování robotů je tak snadné, zpochybňuje rychlost, s jakou jsou tyto systémy zaváděny bez dostatečných bezpečnostních opatření. S rozvojem jazykových modelů a robotů bude nezbytné zajistit jejich odolnost vůči vnější manipulaci, aby se nestaly nástroji ve službách nebezpečného využití.